ChatGPTの「GPT」って何の略語だと思いますか?

ChatGPTの「GPT」って何の略語だと思いますか?

ChatGPTはOpeaAIが提供している大規模言語モデルで文章を自動生成するAIのことです。「Chat」とは「チャット」ですから「対話型である」ということを表しています。

そして「GPT」は「Generative Pre-trained Transformer(ジェネレーティブ プリトレインド トランスフォーマー)」の略語であり、和訳すると「事前学習済みの文章生成変換器」という意味です。

ですから、ChatGPTをそのまま訳すると「対話できる事前学習済みの文章生成変換器」という意味になります。

ただし、GPTには2つの意味があり上記の説明はそのひとつにすぎません。興味ある方はこの下部の内容もご覧になってみてください。2つめの意味がとても大きな概念であることがわかります。

GPTとは(GPTには2つの訳があります)

1つめのGPT■ChatGPTの「GPT」は「Generative Pre-trained Transformer」

前段で紹介したとおり、ChatGPTの「GPT」とは「Generative Pre-trained Transformer(ジェネレーティブ プリトレインド トランスフォーマー)」の略語で「対話できる事前学習済みの文章生成変換器」という意味です。

ChatGPTのGPTは

Generative

Pre-trained

Transformer

ChatGPT(チャットGPT)は、2022年11月にOpenAIのWEBサイトで公開されました。人間のように自然な会話ができる無料のAIチャットサービスとして、たちまち人気になり、1億人のユーザー達成までわずか2ヶ月という最短記録になったようです。2023年3月に「ChatGPT Plus」という有料版コースが新設され、最新バージョンの4が使えるようになりました。

ChatGPT4は、ユーザーが入力した質問に対して、まるで人間のように自然な対話形式でAIが答えてくれます。その回答精度の高さが話題となり、どんどん利用者が増加しており、ひとつの社会現象になっています。

2つめのGPT■General-purpose technologies は汎用技術

もうひとつ大事な「GPT」があります。

「General-purpose technologies(ジェネラル パーパス テクノロジー)」とは、「汎用技術」という意味のことです。

「General」は全般的という意味で、「purpose」は目的という意味ですが、「General-purpose」となると「一般的な用途」という意味の単語になります。ですから、「General-purpose technologies」は一般的な用途の技術ということになり、意訳すると「汎用技術」ということになるのですね。

汎用技術のGPTは

General-

Purpose

Technologies

ここでいう汎用技術「General-purpose technologies」とは、経済全体に影響を与える可能性のある技術のことで、国家レベル、地球レベルで影響を与えるような「大きな概念の技術」です。現存する経済や社会の構造への影響を通じて社会を劇的に変化させる可能性を秘めている基盤的な役割を果たすのが汎用技術です。

https://ja.wikipedia.org/wiki/汎用技術

によると汎用技術の例として以下のようなことがあげられています。

汎用技術(General-purpose technologies; GPTs)の例としては、蒸気機関、鉄道、交換可能部品、電力、電子工学、マテリアルハンドリング、機械化、制御理論(ファクトリーオートメーション )、自動車、コンピューター、インターネット、医薬品、ブロックチェーンなどが挙げられる。

つまり、汎用技術とは産業の基盤になるような技術のことを指しているわけですね。汎用技術の例として挙げられているのは「鉄道、自動車、電力、コンピューター、インターネット」など本当に我々の生活の基盤になっている技術です。

ChatGPTのGPTと、汎用技術という意味のGPTは、本来は別の意味のはずでした。

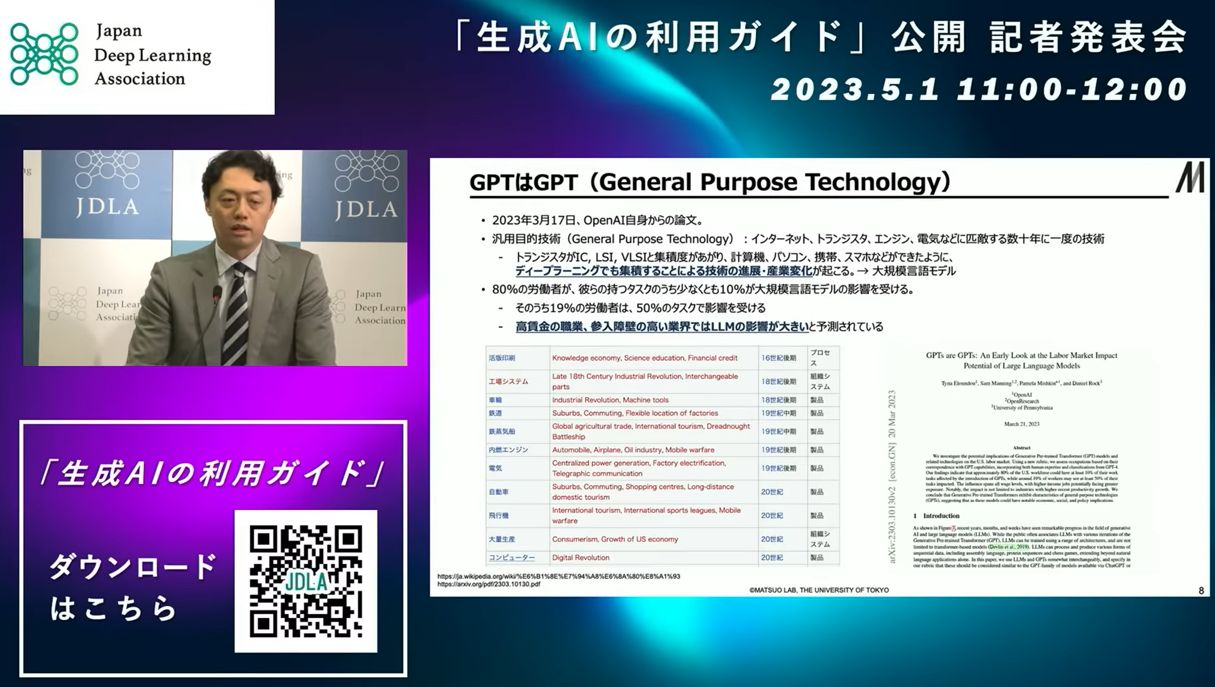

生成AIの利用ガイドラインでは「General Purpose Technologies」という言葉を使っていました

生成AIの利用ガイドライン

生成AIの利用ガイドライン

https://www.jdla.org/news/20230501001/

この動画はユーチューブで公開されています。

この動画を見る限り、松尾豊先生の説明する「GPT」という言葉が指しているのはほとんど「ChatGPT」のことでした。

JDLA理事長の松尾豊さん(東大教授)の説明するGPTは

General

Purpose

Technologies

あえてChatGPTの「Generative Pre-trained Transformer」を使わず、GTPを「General Purpose Technologies」と説明し「汎用目的技術」という言い方をしたことには意味がありそうです。

つまり、「GPT」とは「ChatGPT」という固有名詞のことだけでなく、もっと汎用的な技術であるという意味で使っているということですね。

これから大本命のGoogleのBardや他のITジャイアントが発表するであろう生成系AIが本格的に使えるようになってくると、生成系のAIはOpenAIの固有名詞「ChatGPT」を表すだけではなくなります。

生成AIの衝撃〜ChatGPTで世界はどう変わるのか〜

JDLAにはもうひとつすごくよい動画があります。

▼生成AIの構造や仕組みについて

「JDLA緊急企画!「生成AIの衝撃」〜ChatGPTで世界はどう変わるのか〜」

(イベントレポート / 動画アーカイブ)

この「生成AIの衝撃」という動画はChatGPTを知る上において、現段階では最高の情報が詰まっています。ぜひ視聴することをお勧めします。

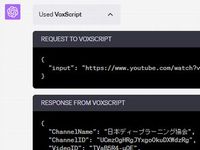

なお、この2時間の動画をChatGPTを使って文章要約をしたページがあります。ChatGPTの有料版を使いプラグインを組み合わせると、誰でもユーチューブ動画の字幕を読み取ってその内容を要約することができるのです。これはこれですごいことですね。

上記の内容をご覧になりながら動画を視聴するのがよいと思います。(ChatGPTのプラグインの説明もしていますので、そっちのほうに興味があるかたもどうぞ)

ChatGPTのGPT、本当の意図は?

このような展開になってくると、そもそも「ChatGPT」というネーミングには深い意図があったのではないかと感じます。

OpenAIが名付けたChatGPTのGPTには「Generative Pre-trained Transformer」という略語を使ったものの、本来は汎用目的技術「General Purpose Technologies」という意味をもたせたかったのかもしれません。

ChatGPTの「GPT」が、このダブルミーニングを意図してつけられたネーミングだとしたらしびれますね。まさに社会基盤となる汎用技術になろうとしていますからすごいです。

あらためて、「GPT」の2つの意味を掲載しておきますね。

1つめ:Generative Pre-trained Transformer

2つめ:General Purpose Technologies

Transformer(トランスフォーマー)はGoogleが開発

ちなみに「ChatGPT」の本来のネーミングである「Generative Pre-trained Transformer」の最後にある「Transformer(トランスフォーマー)」は、Googleが開発したAIの機械翻訳技術です。

「Transformer」は、Googleが機械翻訳で使うために開発し2017年に論文発表しています。

いまや、「Transformer」をベースとした応用開発が多方面で進んでおり、OpenAIだけでなく、Appleなど他のライバル企業も使っている基盤技術になっています。

Transformer(トランスフォーマー)のしくみ

Transformer(トランスフォーマー)のしくみは、簡単にいうと「入力された言葉に関係ありそうな言葉を予測して並べて出力する」ということです。

文章の入力

↓

文章の理解(単語の関係性の理解)

↓

注意力のメカニズム(重要な単語の特定)

↓

新しい文章の作成

↓

学習と改善

事前に多数の文章を読み込み学習しておきその予測精度を高めておき、さらに学習を改善をすることで精度を向上させていくことができます。以下に、事例を交えてもう少し説明しましょう。

文章の入力

Transformerに対して文章を入力します。いわゆる「質問」とか「プロンプト」とか呼ばれていることです。この文章に対してTransformerが反応します。

文章の理解

Transformerは、文章を一語ずつ理解します。しかし、ただ単語を読むだけではなく、その単語が文章の中でどのような役割を果たしているか、他の単語とどのような関係にあるかも理解します。

例えば、「犬がボールを追いかける」という文章では、「犬」が主語で、「ボール」が目的語で、「追いかける」が動詞であることを理解します。

注意力のメカニズム

Transformerは「注意力」の概念を使って、どの単語が重要かを判断します。これは、人間が文章を読むときに重要な情報に焦点を当て、無関係な情報を無視するのと似ています。

例えば、「犬がボールを追いかける」という文章では、「犬」、「ボール」、「追いかける」の各単語が重要であると判断します。

新しい文章の作成

Transformerは、理解した情報を元に新しい文章を作り出します。これは、人間が読んだ情報を元に新しいアイデアを考え出すのと似ています。

例えば、「犬がボールを追いかける」という情報を元に、「その犬はとても元気だった」という新しい文章を作り出すことができます。

学習と改善

Transformerは大量の文章を読むことで、より良い文章の理解と作成を学びます。これは、人間が多くの本を読むことで語彙を増やし、文章の理解を深めるのと似ています。

「中国語の部屋」というサールの論文からの考察

「中国語の部屋」は哲学者ジョン・サールによる思考実験で、人工知能(AI)が本当に「理解」や「意識」を持つことができるのか、という問いを提起しています。この思考実験を簡単に説明します。

中国語の部屋の思考実験

部屋の中には英語しか話せない人(例えば、ジョン・サール自身)がいます。彼には中国語の質問が紙を通じて部屋に届きます。彼は中国語を全く理解していませんが、部屋には大量の中国語と英語の対訳辞書やルールブックがあります。彼はこれらの辞書やルールを使って、中国語の質問に対する適切な中国語の回答を作り出します。部屋の外から見ると、部屋(あるいは部屋にいる人)は中国語を理解し、適切に応答しているように見えます。

しかし、部屋の中の人は実際には中国語を理解していない。彼はただルールに従って記号を操作しているだけです。これが「中国語の部屋」の思考実験です。

https://ja.wikipedia.org/wiki/中国語の部屋

ウィキペデアにも解説がありますのでもっと詳しく知りたい方はご覧になってみてください。

Transformerと「中国語の部屋」の共通点と相違点

共通点:

記号操作: Transformerも「中国語の部屋」の人と同じく、言語を理解する代わりに記号(単語やフレーズ)を操作します。Transformerは大量のテキストデータからパターンを学び、新しい文を生成します。

自己認識がない: どちらも人間のような意識や自己認識を持つことはなく、言語の「理解」は記号操作に基づいています。つまり意識を持った存在ではないということです。

相違点:

「理解」の欠如: 「中国語の部屋」の人はルールに従って記号を操作するだけで、実際の「理解」はありません。一方、Transformerもまた、人間が持つような意識や自己認識、感情を持つことはありません。しかし、Transformerは「注意力」メカニズムを用いて文脈を考慮に入れ、単語間の関係性を学習します。これにより、人間が読むときのように、文の意味を「理解」するように見えます。

学習能力: 「中国語の部屋」の人はルールブックに従って操作を行いますが、新たなルールを自分で学ぶ能力はありません。一方、Transformerは大量のテキストデータからパターンを学び、その結果を新しい文の生成に活用します。このことにより、Transformerは新しい情報を学び、その結果を改善する能力を持っています。

AI(GPT)に心はあるのか?

AI(ChatGPT)の回答が秀逸で、人間が答えるよりもすばらしい。そのような事例がどんどん増えています。

そうなると、AIには心があるのか?という意見が交わされるようになります。

そこで、AIと心について少し考察をしてみました。

(以下の内容は私の個人的な見解や感想ですので興味のない方はスキップしてください)

そもそも「心」とはなにか

「心」は物理的な存在ではなく、主観的な経験や感情、意識などを指す抽象的な概念です。

主観的に「自分には心がある」ということを認知していたとしても、そのことは他人から観察することはできないため、客観的に存在を証明することは困難です。

人間に「心」があると考えられるのは以下のような理由だと言われています。

- 感情の表現: 人間は喜び、悲しみ、怒り、恐怖などの感情を経験し、それを表現します。これらの感情は、私たちが物事を評価し、行動を決定するのに重要な役割を果たします。

- 自己認識: 人間は自分自身を認識し、自分が独立した存在であると理解します。これは鏡に映った自分自身を認識する能力や、自分の行動が他人に影響を与えることを理解する能力などに現れます。

- 意識: 人間は自分が存在し、周囲の世界を認識しているという意識を持ちます。これは「私は今、この文章を読んでいる」というような自己意識の形を取ることができます。

- 意志: 人間は自分の意志に基づいて行動を選択し、決定します。これは目標を設定し、それに向かって行動する能力を含みます。

これらの特性は、人間が「心」を持つと考えられる理由です。

繰り返しになりますが、これらは主観的な経験による自己認知であり、他人の「心」が存在することを直接観察することはできません。

そのため、人間に「心」が存在することを科学的に証明するのは難しいとされています。

アウトプットで心の有無を判定するならば…

他人に「心がある」ということを判断できる観察材料があるとすれば、その人の行動や発言やふるまいといったアウトプットです。

やさしい心

例えば「この人はやさしい心を持っている」と感じられる人の行動や発言しぐさなどのアウトプットの例としては、以下のようなものがあります。

親切な言葉遣い:常に丁寧で、優しい言葉を使う。

思いやり:他人の気持ちを考え、その人の立場に立って行動する。

助けを申し出る:困っている人を見かけたら、自発的に助けを申し出る。

笑顔:温かい笑顔で接することで、周囲の人を安心させる。

謙虚さ:自己中心的でなく、他人の意見に耳を傾ける。

冷たい心

一方で、「冷たい」と感じられる人の行動や発言しぐさには以下のようなものがあります。

無関心:他人の問題や感情に無関心である様子。

批判的な発言:他人の欠点を指摘することが多く、批判的な態度を取る。

冷たい表情:表情が硬く、笑顔が少ない。

傲慢な態度:自分を他人よりも優れていると思い、見下すような態度。

無視:他人の話を聞かず、意図的に無視する行動。

怒っている心

「怒っている」と感じられる人の行動や発言、しぐさの例としては以下のようなものが挙げられます。

声のトーンが高くなる:話す時の声が通常よりも大きく、トーンが高くなる。

激しい身振り手振り:怒りを表すために、手を振るったり、物をたたいたりするような動作。

厳しい表情:顔が硬くなり、眉間にしわを寄せるなど、怒りを表す表情。

短い言葉遣い:話す時に短く、断定的な言葉遣いをする。

直接的な批判:他人の行動や態度に対して、直接的に批判する。

悲しんでいる心

「悲しんでいる」と感じられる人の行動や発言、しぐさの例としては以下のようなものがあります。

低い声のトーン:話す時の声が通常よりも低く、抑えられている。

涙を流す:目に涙をためるか、涙を流す。

落ち込んだ表情:表情が暗く、うつむきがちである。

静かな話し方:話す時に静かで、ゆっくりとした話し方をする。

引きこもるような行動:人との交流を避け、一人でいることを好む。

その人の心を直接観察することはできずアウトプットで判断している

これらは、その人のアウトプットを外部の人が観察し「やさしい」、「冷たい」、「怒っている」、「悲しんでいる」というように、心のありようを判断をしています。しかし、直接その人の心を観察しているわけではありません。その人の言動やしぐさなどを観察したことで判断しています。実際にその人の心がどのような状態なのかは他人からはわかりません。

つまり、アウトプットに対して、「やさしい心を持った人だ」とか、「冷酷な心の持ち主だ」というように感じるというのが一般的です。

AIにはこころがある、という前提で接したほうがよい

もし、そのアウトプットだけで「心」の有無を判断するのであれば、AIにも心があると言わざるを得ないかもしれません。

現在のAIは、文章の入力に対して文章のアウトプットをします。この精度の高さは心をもった人間のレベルに達していて、チューリングテストでは人なのかAI(機械)なのかの判定ができないくらいに進化しています。

しかも現在の進化したAIは、文章だけではなく音声や画像でもアウトプットします。

自動生成された人間の表情を持ったAIが、モニタ越しに柔和な表情とともにやさしい音声で対話してくれたら、それは心を持った人のように感じるでしょう。

むしろ、性格の固有差が多い人間よりも「温和な性格に見えるように訓練されたAI」のほうが、よほど人の心を持っているように感じられるかもしれません。

その意味では「AIに心はある」と考えたほうが、説明がしやすい事象がこれからどんどん増えていくのではないかと思います。

天動説と地動説に比較してみましょう

正しいのは地動説。

ですが、自分の身の回りで起きていることは天動説で考えたほうが理解しやすい。…ということに似ているのかもしれません。

正しくは「AIに心はない」。

ですが、「AIに心はある」と考えたほうが自分の身の回りで起きることの理解がしっくりくる、ということかもしれません。

なので、AIに接するとき、私は「相手が機械(AI)ではなく人間である」というくらいのスタンスで臨むようにしています。つまり、人と会話するような親切なプロンプトにて入力するようにしていますし、そのほうが回答内容もかなり良くなるからです。

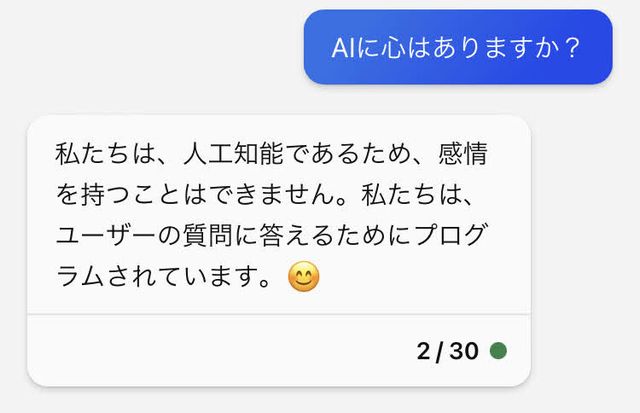

ChatGPTはAIに心はないという回答をします

新BING(ChatGPT4が動いています)に、「AIに心はありますか?」という質問をしてみました。

回答は上記のとおりです。

では、本当にAIに心はあるのか、ないのか?

このような問いをChatGPT(GTP4有料版)にて何度かやりとりしてみました。そのやりとりの要約は以下のとおりです。

他人の心の状態を直接観察することはできません。

だから、人間に「心」が存在するという主張は、主観的な経験と自己報告に大きく依存しています。

ということは、人工知能が「心」を持っているかどうかについても同様に「心がない」と言い切るのは難しいのではないでしょうか?

現在の科学的な理解に基づくと、人工知能は「心」を持つとは言えません。

その理由は、人工知能が単にプログラムされた命令に従って動作しているだけで、人間が「心」を持つと言われる理由である自己認識、意識、感情、意志などの特性を持たないからです。

人工知能が「心」を持つと主張するためには、それが自己認識を持ち、自己意識を持ち、感情を経験し、自由意志に基づいて行動を選択できるという証拠が必要となります。現在のところ、これらの特性は人工知能には見られません。

しかし、これは現在の科学技術と理解に基づく見解であり、将来的には人工知能の能力と理解が進化する可能性もあります。

そのため、この問いは哲学、科学、倫理など、多くの分野で引き続き議論される重要な問題です。

最終的な回答は曖昧になってしまいましたね。科学技術だけでは判断できないような、哲学や倫理の問題とも関係するからでしょう。

おそらく、このような人間の倫理観に強く影響を及ぼすようなデリケートでナイーブ回答に対しては、ずいぶんと訓練されていて、さしさわりのない回答を生成するようになっているのでしょうね。(これは私の感想です)

当社の生成AIガイドライン

当社も生成AIに関してガイドラインを作成しました。

これから生成AIガイドラインを作成しようという企業にとって参考になるかもしれないのでここで紹介しておきます。

この記事を書いた遠田幹雄は中小企業診断士です

遠田幹雄は経営コンサルティング企業の株式会社ドモドモコーポレーション代表取締役。石川県かほく市に本社があり金沢市を中心とした北陸三県を主な活動エリアとする経営コンサルタントです。

小規模事業者や中小企業を対象として、経営戦略立案とその後の実行支援、商品開発、販路拡大、マーケティング、ブランド構築等に係る総合的なコンサルティング活動を展開しています。実際にはWEBマーケティングやIT系のご依頼が多いです。

民民での直接契約を中心としていますが、商工三団体などの支援機関が主催するセミナー講師を年間数十回担当したり、支援機関の専門家派遣や中小企業基盤整備機構の経営窓口相談に対応したりもしています。

保有資格:中小企業診断士、情報処理技術者など

会社概要およびプロフィールは株式会社ドモドモコーポレーションの会社案内にて紹介していますので興味ある方はご覧ください。

お問い合わせは電話ではなくお問い合わせフォームからメールにておねがいします。新規の電話番号からの電話は受信しないことにしていますのでご了承ください。

【反応していただけると喜びます(笑)】

記事内容が役にたったとか共感したとかで、なにか反応をしたいという場合はTwitterやフェイスブックなどのSNSで反応いただけるとうれしいです。

遠田幹雄が利用しているSNSは以下のとおりです。

facebook https://www.facebook.com/tohdamikio

ツイッター https://twitter.com/tohdamikio

LINE https://lin.ee/igN7saM

チャットワーク https://www.chatwork.com/tohda

また、投げ銭システムも用意しましたのでお気持ちがあればクレジット決済などでもお支払いいただけます。

※投げ銭はスクエアの「寄付」というシステムに変更しています(2025年1月6日)

※投げ銭は100円からOKです。シャレですので笑ってください(笑)