明日(2023年6月24日)、生成系AIに関する「JDLA Generative AI Test 2023」という試験が実施されます。実施主体は一般社団法人日本ディープラーニング協会(通称:JDLA)という公的な機関です。現段階で生成系AIに関する知識を証明する試験としてもっとも権威があるパスポートになるかもしれません。

明日(2023年6月24日)、生成系AIに関する「JDLA Generative AI Test 2023」という試験が実施されます。実施主体は一般社団法人日本ディープラーニング協会(通称:JDLA)という公的な機関です。現段階で生成系AIに関する知識を証明する試験としてもっとも権威があるパスポートになるかもしれません。

その試験範囲(シラバス)から重要な用語をピックアップし簡潔な解説をまとめた用語集として作成しました。受験する人の参考になれば幸いです。

「AIテスト」という名称で定着していくかもしれませんね。

- 「JDLA Generative AI Test 2023」

- Generative AI Test 2023 試験対策重要用語

- 「生成AIの技術」の重要用語

- 大規模言語モデル

- 確率モデル

- ハルシネーション(Hallucination)※1

- 基盤モデル

- 言語モデル

- 大規模言語モデル (LLM)

- トランスフォーマー (Transformer)

- アテンション (Attention)

- GPT-3

- 教師あり学習

- 自己教師あり学習

- 事前学習

- ファインチューニング

- アラインメント (Alignment)

- 人間のフィードバックによる強化学習 (RLHF)

- インストラクション・チューニング (Instruction Tuning)

- コンテキスト内学習 (In-Context Learning)

- Zero-Shot

- Few-Shot

- サンプリング手法

- 条件付き生成

- 拡散モデル (Diffusion Model)

- オープンコミュニティ

- オープン大規模言語モデル

- オープンデータセット

- オープンソース

- スケーリング則 (Scaling Laws)

- データセットのサイズ

- データセットの質

- モデルのパラメータ数

- 計算資源の効率化

- GPU

- マルチモーダル

- 学習データの時間的カットオフ

- 大規模言語モデルの知識

- 大規模言語モデルの不得意タスク

- 生成AIの活用事例

- 「生成AIの利活用」の重要用語

- 「生成AIのリスク」の重要用語

- 「生成AIの技術」の重要用語

- 生成AIの利用ガイドライン

- 第1回のAIテストに合格しました

「JDLA Generative AI Test 2023」

「JDLA Generative AI Test 2023」が正式名称

この生成系AIの検定試験については以下のURLにて受験要領が公開されています。

詳細は上記URLでご確認ください。

Generative AI Testの試験内容(シラバス)

「生成AIの技術」、「生成AIの利活用」、「生成AIのリスク」、という3つの分野から出題されるようです。

この試験では、下記項目のような観点から、「生成AIに関する基礎知識を有し、適切な活用方針を決定できるかどうか」を確認できます。

・生成AIについて、おおよその構造や仕組みが理解できている

・生成AIを活用する上で、知っておくべきことが理解できている

・生成AIを活用する上で、注意すべきことが理解できている

・生成AIの活用法がイメージできている

試験概要についてはこのページでも紹介しています。

当ページではシラバスに掲載されていて、重要そうな試験対策用語について調べてみました。以下に用語集として紹介しておきます。

※なおこの用語集は遠田幹雄本人が受験のための学習の過程でChatGPTを活用して作成しまとめたメモをもとに作成しています。正確かどうかについては確証がありません。あくまで参考情報としてください。ご利用は計画的に(笑)

Generative AI Test 2023 試験対策重要用語

「生成AIの技術」の重要用語

「生成AIの技術」に関して、大規模言語モデル、テキスト、画像、音声等の生成モデルに共通する技術的な特徴を俯瞰して理解していることなど。

大規模言語モデル

大規模言語モデルは、ある単語またはフレーズが与えられたとき、次に来る単語またはフレーズを予測する能力を持つ機械学習モデルです。最も有名な大規模言語モデルの一つにOpenAIのGPT(Generative Pretrained Transformer)があります。これらのモデルは非常に大量のテキストデータ(インターネット上の文章など)を学習し、文の構造、意味、文脈などを理解することで、人間らしいテキストを生成することができます。モデルは通常、損失関数に基づいてパラメータを調整し、次に来る単語の予測精度を向上させます。

確率モデル

確率モデルは、ランダムな事象の出現確率を記述するための数学的なフレームワークです。これらのモデルは、特定の事象の確率を予測し、その事象が他の事象とどのように関連しているかを理解します。言語モデルのコンテキストでは、確率モデルは特定の単語が与えられた文脈でどのくらいの確率で現れるかを予測します。これにより、言語モデルは自然言語生成タスクにおいて意味のある予測を行うことができます。

ハルシネーション(Hallucination)※1

ハルシネーションは、AIが存在しない情報やパターンを「見」たり「予測」したりすることを指す一般的な用語です。大規模な言語モデルのコンテキストでは、モデルが学習データにない情報を生成することを指します。これはしばしば、モデルが入力に基づいて「創造的」な出力を生成するときに見られます。例えば、GPT-3は新しい物語を作り出したり、未解決の問題に対する可能性のある解答を提供したりします。ただし、ハルシネーションは必ずしも正確または信頼性の高い情報を生成するわけではないため、その使用には注意が必要です。具体的には、言語モデルが既存の知識を基に新しい情報を「創造」するとき、その情報が事実に基づいている保証はありません。これは特に、偽のニュース生成や誤情報拡散の可能性がある状況で問題となります。

また、生成された内容がモデルの訓練データに含まれていないことから、言語モデルが「新しい」情報を提供しているように見える場合でも、それは単に既存の情報を新たな形で再構築したものである可能性が高いと理解することも重要です。

基盤モデル

基盤モデルは、大規模なデータセットから学習を行い、特定のタスクに特化しない一般的なパターンを学習したモデルを指します。これは、新たなタスクに対してはファインチューニングというプロセスを通じて適応されます。具体的な例としては、OpenAIのGPT-3があります。

言語モデル

言語モデルは、人間の言語のように文を生成するための計算モデルです。これは、単語、フレーズ、文、あるいはその他の言語単位の出現確率を学習し、それに基づいて新たなテキストを生成します。

大規模言語モデル (LLM)

大規模言語モデルは、非常に大量のテキストデータ(しばしばインターネットから集められたもの)から学習した言語モデルを指します。大規模言語モデルは、広範で深い知識を持つことで、より洗練された文を生成したり、質問に答えることができます。

トランスフォーマー (Transformer)

トランスフォーマー(Transformer)は、Googleが開発した自然言語処理(NLP)のタスク、特に機械翻訳や文章生成などにおいて効果的な深層学習モデルです。トランスフォーマーは”Attention is All You Need”という論文で2017年に初めて紹介されました。

トランスフォーマーモデルの主要な特徴は、アテンション(attention)メカニズムを用いることで、入力データの全範囲を見渡すことができ、各単語の関連性を重み付けることができます。このアテンションメカニズムは、自己注意(self-attention)またはトランスフォーマー注意(transformer attention)とも呼ばれ、モデルが入力文中の任意の位置間の依存関係を直接計算することが可能になります。これにより、伝統的なリカレントニューラルネットワーク(RNN)のようなモデルが抱える長距離依存関係の問題を克服しています。

トランスフォーマーモデルは、エンコーダー部分とデコーダー部分から構成されています。エンコーダーは入力文を連続的なベクトル表現に変換し、デコーダーはこのベクトル表現を基に出力文を生成します。

GPT-3やBERTなどの現代的な大規模言語モデルは、トランスフォーマーのアーキテクチャを基礎としています。これらのモデルは、モデルの大きさや訓練データの量を増加させることで、驚くべき結果を生み出すことができています。

アテンション (Attention)

アテンションは、トランスフォーマーモデルにおける重要な概念で、モデルが入力の中から注目すべき部分に「注意」を向けるメカニズムを指します。これにより、モデルは文の構造をより良く理解し、適切な応答を生成することができます。

GPT-3

GPT-3(Generative Pretrained Transformer 3)は、OpenAIによって開発された大規模なトランスフォーマーベースの言語モデルです。数十億件の単語を学習し、その結果として人間らしいテキストを生成する能力を持っています。これは非常に大規模なモデルであり、そのパラメータ数は1750億以上にも及びます。GPT-3は、事前に大量のテキストデータ(ウェブページ、書籍など)を学習し、その後特定のタスクに対してファインチューニングを行うことができます。この能力により、GPT-3は様々なタスクに対応でき、例えば文章の生成、質問応答、文章の要約、翻訳、情報の抽出などが可能です。

教師あり学習

教師あり学習は機械学習の最も一般的な形式の一つで、アルゴリズムはラベル付きの訓練データから学習します。この場合、ラベルはターゲットまたは目標出力で、各入力データに対応しています。教師あり学習の目的は、新たな未知のデータに対して正確な予測を行うモデルを訓練することです。

自己教師あり学習

自己教師あり学習は、ラベルが明示的に提供されないデータからモデルが学習する方法です。代わりに、モデルはデータ自体からラベルを生成し、それを使用して学習します。この手法は、大量の未ラベルデータを利用できる場合に特に有用です。

事前学習

事前学習は、特定のタスクについてモデルを訓練する前に、一般的なタスクでモデルを訓練するプロセスです。これは、特定のタスクにおけるモデルのパフォーマンスを向上させるために行われます。事前学習では、通常大量のデータを用いて広範な知識を学習し、その後で特定のタスク(例えば、特定のクラスの画像分類)に向けたファインチューニングが行われます。

ファインチューニング

ファインチューニングは、事前学習したモデルの重みを特定のタスクに適合させるプロセスです。事前に訓練されたモデル(通常は大量のデータで訓練されたモデル)を基に、タスク特有のデータでモデルを再訓練します。これにより、モデルは特定のタスクに対するパフォーマンスを大幅に改善することができます。

アラインメント (Alignment)

AIのコンテキストでは、アラインメントは一般的にAIの目標や行動が人間の価値観や目標と一致するようにすることを指します。これはAIの安全性と倫理性を確保するための重要な概念であり、特に強力なAIシステムや自律的なAIシステムを設計する際に重要です。アラインメント問題は、AIが人間の意図した目標を理解し、それに従って行動する能力を持つことを指します。例えば、AIが人間の説明したタスクを適切に理解し、それに基づいて動作する場合、そのAIはタスクに「アライン(一致)」していると言えます。

人間のフィードバックによる強化学習 (RLHF)

人間のフィードバックによる強化学習(Reinforcement Learning from Human Feedback, RLHF)は、人間の評価やフィードバックを使用してAIシステムを学習させ、行動を調整する方法です。人間がAIの行動を評価し、そのフィードバックを報酬としてAIに供給します。AIはこのフィードバックを用いて自身の行動を調整し、次第により良い結果を得るための行動を学習します。これは、人間の価値観や目標をAIに伝えるための有効な方法であり、AIのアラインメントを実現する一つの手段とされています。

インストラクション・チューニング (Instruction Tuning)

インストラクション・チューニングは、AIモデルが指示を適切に理解し、それに従って行動するように調整するプロセスです。具体的には、AIモデルのパラメータを調整し、人間からの指示を正確に解釈し、それに対応する適切な行動を行う能力を向上させることを目指します。これは、モデルのアラインメントを改善し、より人間の価値観や目標に一致した行動を促す一つの方法です。

これらの概念は、AIの倫理性、安全性、そして有効性を確保するための重要な工程を形成します。AIが人間の目標や価値観にアラインすることは、AIが持つ潜在的なリスクを軽減し、人間中心の有益なアウトプットを達成するために重要です。

人間のフィードバックによる強化学習(RLHF)とインストラクション・チューニングの違いについては以下のとおりです。

人間のフィードバックによる強化学習(RLHF)は、AIが人間の意図した行動を学習し、その結果を改善するための一つの具体的な手法です。この手法は、人間が提供するフィードバックを通じてAIの行動を指導し、最終的には人間の目標と一致する行動をAIに学習させることを可能にします。

一方、インストラクション・チューニングは、AIが人間からの指示を適切に解釈し、それに従う能力を向上させるための手法です。これにより、AIは指示されたタスクをより正確に実行でき、それにより人間の目標により近づくことができます。

コンテキスト内学習 (In-Context Learning)

大規模言語モデルは、与えられたコンテキスト内で情報を学習し、その学習を元に出力を生成します。訓練データから学習したパターンを利用し、新たなコンテキストを理解し、それに適したレスポンスを生成します。これは一種のオンライン学習で、モデルが新しい情報を取り込みながらその場で適応する能力を表しています。

Zero-Shot

Zero-Shot学習は、モデルが訓練データに含まれていない特定のタスクを実行する能力を指します。つまり、特定のタスクに対して、そのタスクに関する例を見ずに適切な予測を行うことが期待されます。この能力は、モデルが一般的なパターンや概念を学習し、それを未知の状況に適用する能力に依存しています。

Few-Shot

Few-Shot学習は、モデルがわずかな訓練例(例えば、タスクに関連する数件のデータ点)から新たなタスクを学習し、適切な予測を行う能力を指します。これは、特定のタスクに関する大量のラベル付きデータが利用できない状況で非常に有用です。

サンプリング手法

大規模言語モデルの出力は、通常、確率的なサンプリングによって生成されます。つまり、モデルは出力として可能な全てのテキストのうち一つを選択しますが、その選択はモデルが学習した確率分布に従います。サンプリングの戦略はさまざまで、贪欲なサンプリング、ビームサーチ、トップ-kサンプリング、トップ-pサンプリング(ニュークリウスサンプリング)などがあります。これらのサンプリング戦略は、生成されるテキストの多様性と一貫性のバランスを制御するために使われます。

条件付き生成

条件付き生成は、特定の条件に基づいてデータを生成するモデルの設計方法を指します。例えば、条件付き生成のモデルは、与えられたテキストに基づいて画像を生成したり、与えられたキーワードに基づいて文を生成することができます。この方法は、モデルが生成する出力をより細かく制御するために使用されます。

具体的な技術としては、条件付きGAN(Generative Adversarial Network)などがあります。

GANとは、敵対的生成ネットワークといわれており、用意されたデータから特徴を学習し擬似的なデータを生成することができる生成モデルです。GANは、Goodfellowらによって2014年に発表され、画像生成に関してすばらしい成果を上げたため当時は注目を集めました。

拡散モデル (Diffusion Model)

拡散モデルは、データ生成の一つの方法で、データが確率的な拡散プロセスによって生成されるという考え方に基づいています。これは、データの元の分布から始まり、徐々にノイズが加わり、最終的な分布に収束するプロセスをシミュレートします。

訓練フェーズでは、モデルは元のデータからノイズを加えてゆく逆プロセスを学習します。そして、生成フェーズでは、モデルはこのプロセスを逆に行い、ランダムなノイズから元のデータ分布に近いサンプルを生成します。

拡散モデルは、高品質な画像生成などに成功しており、最新の生成モデルの研究で注目を浴びています。OpenAIの「DALL·E」や「Image GPT」などのモデルは、これらの概念を使用して高品質な画像を生成しています。

オープンコミュニティ

オープンコミュニティは、特定のテーマや目的に集まった人々のグループで、その情報、リソース、アイデアを自由に共有し、協力して活動を進めるものを指します。オープンコミュニティは、透明性、協力、共有の原則に基づいており、参加者は共同で価値を創造し、組織全体を成長させます。

オープン大規模言語モデル

オープン大規模言語モデルとは、訓練方法、アーキテクチャ、さらには訓練済みのモデル自体が公開されている大規模な言語モデルを指します。これにより、他の研究者や開発者がモデルを自由に利用、改善、適応することが可能になります。GPT-2やBERTなどのモデルがこれに該当します。

オープンデータセット

オープンデータセットは、一般的に公開され、誰でも自由に利用できるデータセットのことを指します。これらは研究、教育、製品開発など、様々な目的に使用することができます。オープンデータセットの例としては、Wikipediaのテキストデータや、ImageNetなどの画像データセットがあります。

オープンソース

オープンソースは、そのソースコードが公開されていて、誰でも自由に閲覧、修正、配布することができるソフトウェアのことを指します。これにより、開発者は既存のコードを基に新しいソフトウェアを作ったり、既存のソフトウェアを改善したりすることができます。

スケーリング則 (Scaling Laws)

スケーリング則とは、AIや機械学習モデルのパフォーマンスが、学習データの量、モデルの大きさ(パラメータ数)、または計算リソースの規模に対してどのようにスケールするかを記述する法則です。一般的に、これらのリソースを増やすと、学習モデルのパフォーマンスも改善するとされています。ただし、それぞれのスケーリングには限界があり、ある程度以上になるとパフォーマンスの向上が減速するとされています。

データセットのサイズ

データセットのサイズとは、訓練データセットに含まれるデータの総量を指します。一般的に、データセットが大きければ大きいほど、モデルはより多くの情報を学習し、その結果、パフォーマンスが向上するとされています。

データセットの質

データセットの質は、そのデータがどれほど正確で、タスクに対して有用な情報を含んでいるかを指します。ノイズの少ない、適切にラベル付けされた、バランスの良いデータセットは、良質なデータセットと見なされます。

モデルのパラメータ数

モデルのパラメータ数は、モデルの複雑さを示します。パラメータ数が多ければ多いほど、モデルはより複雑なパターンを学習できますが、同時に過学習のリスクも増えます。

計算資源の効率化

計算資源の効率化とは、利用可能な計算能力を最大限に活用するための工夫や技術のことを指します。これには、ハードウェアの最適化、アルゴリズムの効率化、並列処理、分散計算などが含まれます。

GPU

GPU(Graphics Processing Unit)は、元々はグラフィックス処理に特化したコンピューティングデバイスですが、その並列処理能力が機械学習、特に深層学習の計算に有効であることから、現在ではAIの分野でも広く活用されています。深層学習では、大量の行列計算や並列計算が必要となりますが、GPUはこれらのタスクを効率的に処理できる構造を持っています。そのため、現在の深層学習のフレームワークでは、GPUを活用して高速に計算を行うことが一般的です。

マルチモーダル

大規模言語モデルは、元々はテキストデータから自然言語の理解や生成を行うためのものでしたが、最近ではマルチモーダル(複数の種類のデータを扱う)モデルへと進化してきています。つまり、これらのモデルはテキストだけでなく、画像や音声といった別種類のデータも理解し、これらを組み合わせたタスクを解くことができるようになってきています。

このような動向が生じている原因はいくつかありますが、主なものは以下の通りです。

・データの豊富さ: デジタル化された情報は、テキストだけでなく、画像や音声、動画など様々な形式で存在しています。これら全ての情報を統合して理解することで、より深い洞察を得ることが可能になります。

・人間との自然なインタラクション: 人間は、情報を伝えるためにテキストだけでなく、画像や音声といった多様なモードを使います。マルチモーダルなモデルは、人間とより自然にコミュニケーションを取ることが可能です。

・パフォーマンスの向上: テキストと他のモードのデータを組み合わせることで、多くのタスクにおいてパフォーマンスが向上することが示されています。

例えば、OpenAIの「CLIP」は、テキストと画像を同時に理解することができるマルチモーダルなモデルで、テキストの説明から画像を見つける、あるいは画像からテキストを生成するといったタスクを行うことができます。同様に、「DALL-E」は、テキストの説明から画像を生成することができるモデルで、これにより「テキストで描写された未知の事物の画像を生成する」という驚異的なタスクを達成しています。

これらのマルチモーダルなモデルは、AIが人間のように世界を理解する一歩とも言えるでしょう。

学習データの時間的カットオフ

学習データの時間的カットオフは、大規模言語モデルが訓練されたデータセットの最新の情報の日付を指します。たとえば、OpenAIのGPT-4のカットオフは2021年の9月となっており、それ以降の情報についてはモデルが知識を持つことはありません。それは、訓練データにそれ以降の情報が存在しないためです。

大規模言語モデルの知識

大規模言語モデルは訓練データから多様な知識を学習します。これには一般的な知識、特定の領域の専門知識、さまざまなタスクを実行するための方法などが含まれます。しかし、その知識は訓練データに基づいています。そのため、訓練データが偏っていたり、誤った情報を含んでいると、それがモデルの出力にも反映されます。

大規模言語モデルの不得意タスク

大規模言語モデルは一般的な知識を持っているため、多くのタスクをこなすことが可能です。しかし、非常に特定の専門知識を必要とするタスクや、常識や直感を必要とするタスク、未学習の新しい情報に基づくタスクなどには苦戦することがあります。また、モデルは基本的に過去のデータから学習するため、未来を予測するタスクはその本質上難しいです。さらに、明確な答えが存在せず主観的な判断が必要な問いに対する回答も難しい場合があります。

生成AIの活用事例

コンテンツ生成: ブログ記事やニュースレポート、広告コピーなどを生成するためにAIを使用。言語モデルは一連のプロンプトに基づいて文を生成し、人間のライターが編集を行う。

カスタマーサポート: 顧客からの質問に対して即時にレスポンスを提供するために、AIチャットボットが使用される。人間味があるAIのカスタマーサービスで顧客体験を改善するとともに、顧客対応コストの削減を可能にし、企業のカスタマーサービスを革新している。

エンターテイメント: 映画やアニメ、ゲームのスクリプト生成、またはキャラクターの対話生成にAIを使用。また、AIが生成した音楽やアートも人気を博している。

教育: 例えば、英語学習アプリではAIが生成した文を学習材料として使用。また、AIチューターを使用して、個々の学生に合わせた学習経験を提供。

ヘルスケア: 医療情報の分析や診断サポートに生成AIを使用。たとえば、医療レポートの自動生成や、患者の自己報告に基づく初期診断の提供。

「生成AIの利活用」の重要用語

生成AIには何ができるのかを理解したうえで、新たな活用方法を生み出すためのアプローチや制限要因などを理解しているか、など。

ケイパビリティ(Capability)

「ケイパビリティ」(Capability)とは、あるシステムやモデルがどのような機能や能力を持つのか、何を達成できるのかを示す一般的な用語です。生成AIにおけるケイパビリティは、そのAIが何を生成できるか、どのような種類の問題を解決できるか、どのように機能するかに関連しています。

生成AIはその名の通り、何かを「生成」する能力を持っています。具体的には、テキスト、画像、音楽、音声などのデータを生成することが可能です。そして、それらの生成は、指定された要件や条件に従って行われます。たとえば、大規模な言語モデルは、与えられたプロンプト(開始テキスト)に基づいて続きのテキストを生成することができます。

しかし、生成AIのケイパビリティは、ただ単にデータを生成するだけにとどまりません。多くの場合、それらの生成物は特定の目的を果たすように設計されています。例えば、質問応答システムでは、ユーザーからの質問に対して適切な回答を生成します。また、文章生成システムでは、与えられたテーマやスタイルに基づいて記事やエッセイを生成します。

さらに、一部の生成AIは、未知のタスクに対応するための「一般化」能力を持っています。つまり、訓練中に直接経験したことのない新しいタスクでも、それを達成するための新しい解答や出力を生成することができます。これは、大規模な言語モデルが「zero-shot」や「few-shot」学習を行うことで可能となります。

しかし、生成AIが何を生成できるかは、その訓練データやモデルの設計、そして学習方法によって大きく左右されます。また、生成AIのケイパビリティはその強力さゆえに、倫理的な観点からも慎重な取り扱いが求められます。生成物が偽情報や誤解を招く可能性があるからです。

プロンプトエンジニアリング

「プロンプトエンジニアリング」は、AIの出力を最適化するために使用される入力(プロンプト)をうまく設計する技術のことを指します。これは大規模な言語モデルのような生成AIの領域で特に重要で、プロンプトはモデルに対する問いや指示を表します。

プロンプトエンジニアリングは、AIに求める回答をより精密に、あるいはより特定の方法で生成させるためのテクニックで、プロンプトの形式や言葉の選び方、詳細度などを工夫します。

例えば、ある問いに対してAIがあいまいな回答をする場合、プロンプトを改良して具体的な情報を要求するように指示すると、AIの回答がより具体的になる可能性があります。

また、多くのAIモデルは、プロンプトの情報から何をすべきかを推測します。したがって、プロンプトがモデルの行動を適切に指導できるように設計されていることが重要です。

簡単に言えば、プロンプトエンジニアリングは、「AIに何を尋ねるか」だけでなく、「どのように尋ねるか」を最適化する技術のことです。「問う能力」がとても重要になっています。

にも関連記事があります。

ハッカソン

ハッカソンは、限られた時間内で、個々またはチームで新しいソフトウェアや技術的解決策を開発するイベントです。生成AIのコンテキストでは、ハッカソンは参加者が新しい応用例を発見し、新しい技術を試す機会を提供します。それらの応用例は、商業的な製品やサービス、社会的な問題解決、クリエイティブなプロジェクトなど、様々な範囲に及びます。

自主的なユースケース開発

個々の開発者や組織が自己主導で新しい生成AIの利用法を開発することも可能です。これには、自分自身の問題やニーズを解決するための新しいツールやサービスの開発、新しい市場やビジネスモデルの探求などが含まれます。

インターネット・書籍

インターネットや書籍は、新しい生成AIの応用を学ぶための主要なリソースです。オンラインのチュートリアルやコース、ブログ記事、論文、技術書などから、生成AIの基本的な原理や最新の研究成果、成功事例などを学ぶことができます。

活用の探索

これは、新しい技術やツールを試し、可能性を探るための一般的なアプローチです。これには、さまざまなデータセットやタスクで生成AIモデルを訓練したり、既存のモデルを新しい方法で利用したりするなどの活動が含まれます。活用の探索は、新しい知見を得るための実験的な取り組みであり、この過程で新たな応用が見つかることもあります。

生成AIの学習データ

生成AIの能力は、その学習データに大きく依存します。十分な量と質の学習データがなければ、AIは高度な生成タスクを達成できません。特に、タスクが特定の専門知識やコンテキストを必要とする場合、関連するデータが不足していると、AIの性能が低下します。また、学習データに偏りやバイアスが存在すると、それがAIの出力にも反映され、問題を引き起こす可能性があります。

生成AIの性能評価

生成AIの性能を評価することは困難な場合があります。特に、生成タスクが主観的またはクリエイティブな要素を含む場合、”正しい”出力が何であるかを決定するのは難しいです。その結果、モデルが生成した結果が本当に良いものなのか、適切な評価指標で評価しなければ、正確には分かりません。

生成AIの言語能力

生成AI、特に大規模な言語モデルは、一般的には人間と同等の言語理解能力を持つとは言えません。それらは、広範なデータを学習して高度なパターンマッチング能力を獲得しますが、人間のような意味の理解や複雑な論理推論を行う能力は持っていません。その結果、モデルが誤解を引き起こす可能性があり、また、専門的な知識や複雑な問いに対する回答の信頼性が必ずしも高くないという問題があります。

ChatGPT

ChatGPTは、OpenAIが開発した人間のように会話することができる大規模な言語モデルです。その基盤となる技術はGPT(Generative Pretrained Transformer)で、特に最新版のGPT-3は1750億のパラメータを持つ非常に大規模なモデルです。

ChatGPTはインターネット上の大量のテキストデータを事前学習することで、人間のような文章を生成する能力を獲得しています。その後、人間とAIの間で行われた会話データを用いて、対話型のタスクに対してファインチューニングを行います。

具体的な使用例としては、カスタマーサポートの自動化、コンテンツ作成(例えば、記事の草稿作成や広告のコピーライティング)、教育的なシナリオ(例えば、学習者が質問に対して答えを得る)などがあります。ただし、モデルは完全には理解していないため、一部の問いに対しては不正確または誤った回答をする可能性があります。

ChatGPTは、その性能や適用可能性からAI研究者や開発者の間で広く使用されています。また、OpenAIの政策により、安全性や利用者のプライバシーを守るためのガイドラインが設けられています。

Bard

BardはGoogleによって開発されたAIで、最新の大規模言語モデル(LLM)である「PaLM 2」を搭載し、ChatGPTに匹敵する能力をもっていると言われています。PaLM 2は、多言語、推論、およびコーディング機能が向上した最先端の言語モデルで、100以上の言語のテキストを学習し、慣用句、詩、なぞなぞなど、ニュアンスを含む表現を数多くの言語で理解、生成、翻訳するといった難しい問題に対する性能が大幅に向上。上級レベルの言語能力試験で「習得」レベルに合格したという。

また、推論機能は、数式を含む科学論文やウェブページから学習。ロジックや、常識に基づく推論、数学に関する能力が向上しているという。また、公開されている大量のソースコードデータセットからの学習により、PythonやJavaScriptといったメジャーなプログラミング言語だけでなく、Prolog、Fortran、Verilogといった言語のコードも生成できる。

広告クリエイティブへの応用

生成AIは広告クリエイティブにも適用されています。AIは、広告のコピー、ヘッドライン、製品の説明などを生成することが可能で、これにより広告制作のプロセスを迅速化し、効率化します。また、AIは大量の広告データから学習するため、広告の効果を最大化するための言葉遣いやフレーズの傾向を抽出することが可能です。

ドメイン固有

ドメイン固有の生成AIは、特定の業界や分野に特化した知識を持っています。これは、医療、法律、金融などの専門分野で特に価値があります。このようなモデルは特定のタスク(診断の補助、法的な文章の作成、金融市場の予測など)に対して、専門家レベルの知識を持つことが期待されます。ただし、これらのモデルの訓練と評価は一般的なモデルよりも困難で、ドメインの専門知識を持つ人々の協力が必要です。

「生成AIのリスク」の重要用語

生成AIのリスクについて、生成AIが、技術面・倫理面・法令面・社会面などで多様なリスクを孕むことを理解しているかどうかの確認です。

ハルシネーション(Hallucination)※2

ハルシネーションとは、AIが存在しない情報や事実を「見つける」ことです。これは、AIがデータのパターンを過度に一般化し、存在しないパターンや関連性を誤って推測する結果として生じます。「生成系AIは嘘をつく」と言われている現象がこれです。

※上記の「生成AIの技術」の項目内にもハルシネーション※1の用語が出ていますのでそちらも参考にしてください。

セキュリティ

生成AIは悪意のある者によって、偽の情報を広めるツールや、人々をだますためのツールとして使用されるリスクがあります。たとえば、ディープフェイク(人工的に生成されたリアルな画像や動画)は、誤った情報を広めるのに使われ、人々の信頼を損なうことがあります。

公平性

AIモデルは学習データに含まれるバイアスを学習する可能性があります。これは、モデルの出力が特定の人々やグループに対して偏ったものになり、不公平を生む可能性があります。

プライバシー

大規模なデータセットを学習するAIモデルは、個人情報を含む可能性があります。モデルがこのような情報を学習し、生成する出力に反映されると、プライバシーの侵害につながります。

透明性

AIモデルの動作の理解は、専門的な知識を必要とし、モデルの意思決定プロセスが透明でない可能性があります。これは、「ブラックボックス」問題とも呼ばれ、AIの判断の公正性や信頼性を評価するのが難しくなる可能性があります。

著作権

生成AIの学習データや出力が著作権法に抵触しないようにすることが重要です。特に、モデルが著作権を持つコンテンツを生成する場合や、著作権を持つコンテンツを学習データとして使用する場合は注意が必要です。

個人情報

生成AIの学習データに含まれる個人情報の取り扱いは、プライバシー法規制やGDPR(EU一般データ保護規則)などによって厳格に制限されています。AIが個人情報を学習し、それを出力として公開すると、プライバシーの侵害になる可能性があります。

機密情報

機密情報は、企業や組織の秘密や知的財産を含む可能性があります。生成AIがこのような情報を学習や生成に使用すると、機密保持契約や法律に違反する可能性があります。

商用利用

生成AIの出力を商用利用する場合は、商用利用が許可されているかどうか、またその条件は何かを確認する必要があります。特に、特許、商標、著作権などの知的財産権を含む可能性があります。

利用規約

AIの利用規約は、AIを使用する際のルールを定めています。これには、AIの使用方法、権利、義務、制限などが含まれます。規約に違反すると、法的な問題が生じる可能性があります。

新たなリスク

現在まだ認識されていない新たなリスクの一例としては、AIによる内容生成がますます洗練されることで、人間が生成したものとAIが生成したものを区別することが難しくなる可能性があります。これにより、情報の信頼性や真実性を評価することが困難になり、偽情報の拡散や詐欺行為などのリスクが増大する可能性があります。

規制化

生成AIのリスクを管理するために、政府や規制当局が新たな規制を導入する可能性があります。規制は、特定の使用例を禁止するものから、データ使用のガイドラインを設定するもの、AIの透明性や説明可能性を要求するものなど、多様な形を取ることがあります。

情報収集

未知のリスクを理解し、それに対処するためには、情報収集が重要です。これには、AIの最新の研究成果、技術動向、社会的影響、規制の動向などを定期的に監視し、分析することが含まれます。

自主対策

AIを使用する企業や組織自身が自主的に対策を講じることも重要です。これには、AIの使用に関する内部ガイドラインの策定、AIのリスク評価と管理のためのシステムの導入、AIの適切な使用を促す教育と訓練の提供などが含まれます。

以上のように、生成AIには未知のリスクが伴いますが、情報収集と自主対策を通じて、これらのリスクを理解し、管理することが可能です。規制当局との協力も重要で、AIの安全かつ有益な利用を実現するための規制環境の形成に寄与することが求められます。

生成AIの利用ガイドライン

JDLA公開 生成AIの利用ガイドライン

JDLAは生成AIの利用ガイドラインの案を2023年5月1日に公開しています。

この内容はそのまま試験対策としても使えますので目を通しておきましょう。

なおこの内容は試験対策が主目的ではありません。(当然ですが)

企業がAIガイドラインとして作成することが目的なので、この内容を参考にして各社が自社のAI活用ガイドラインを作ることを推奨します。

JDLA公開記者発表会の様子

また、公開記者発表会の様子は以下の公開動画のなかで詳しく述べられており、そのほぼ全内容が公開されています。

この動画内容も試験対策として有用です。一度は視聴しておきましょう。

学習のための事例として株式会社ドモドモコーポレーションの生成系AI利用ガイドラインを試作してみました。(当初は学習用サンプルとして作成しました)

株式会社ドモドモコーポレーションの生成系AI利用ガイドライン

上記のガイドライン案を参考にして、正式に当社の「生成系AI活用ガイドライン(AIガイドライン)」を作成しました。

興味ある方は上記ページもご覧になってみてください。

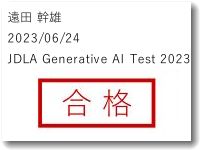

第1回のAIテストに合格しました

このAIテストに私自身が受験した結果は、合格でした。

第1回のAIテストは、シラバスをきちんと理解しておけばかなりいい線まで対応できました。ありがとうございます。

その後、JDLAのAIテスト合格者にオープンバッジが授与されました。ちょっとうれしい出来事でした。

この記事を書いた遠田幹雄は中小企業診断士です

遠田幹雄は経営コンサルティング企業の株式会社ドモドモコーポレーション代表取締役。石川県かほく市に本社があり金沢市を中心とした北陸三県を主な活動エリアとする経営コンサルタントです。

小規模事業者や中小企業を対象として、経営戦略立案とその後の実行支援、商品開発、販路拡大、マーケティング、ブランド構築等に係る総合的なコンサルティング活動を展開しています。実際にはWEBマーケティングやIT系のご依頼が多いです。

民民での直接契約を中心としていますが、商工三団体などの支援機関が主催するセミナー講師を年間数十回担当したり、支援機関の専門家派遣や中小企業基盤整備機構の経営窓口相談に対応したりもしています。

保有資格:中小企業診断士、情報処理技術者など

会社概要およびプロフィールは株式会社ドモドモコーポレーションの会社案内にて紹介していますので興味ある方はご覧ください。

お問い合わせは電話ではなくお問い合わせフォームからメールにておねがいします。新規の電話番号からの電話は受信しないことにしていますのでご了承ください。

【反応していただけると喜びます(笑)】

記事内容が役にたったとか共感したとかで、なにか反応をしたいという場合はTwitterやフェイスブックなどのSNSで反応いただけるとうれしいです。

遠田幹雄が利用しているSNSは以下のとおりです。

facebook https://www.facebook.com/tohdamikio

ツイッター https://twitter.com/tohdamikio

LINE https://lin.ee/igN7saM

チャットワーク https://www.chatwork.com/tohda

また、投げ銭システムも用意しましたのでお気持ちがあればクレジット決済などでもお支払いいただけます。

※投げ銭はスクエアの「寄付」というシステムに変更しています(2025年1月6日)

※投げ銭は100円からOKです。シャレですので笑ってください(笑)