ChatGPTの新しいモデルとして「4o-mini」が追加されました。この「4o-mini」は「4o」の小型版で、最大の特徴は軽くて早いということです。実際に使ってみるとたしかに回答速度が早いですが、高性能というわけではなさそうです。どうしてOpenAI社はこのようなモデルを発表したのでしょうか。

ChatGPTの新しいモデルとして「4o-mini」が追加されました。この「4o-mini」は「4o」の小型版で、最大の特徴は軽くて早いということです。実際に使ってみるとたしかに回答速度が早いですが、高性能というわけではなさそうです。どうしてOpenAI社はこのようなモデルを発表したのでしょうか。

背景として、生成AIが戦国時代になっており性能競争が激化していることがあげられます。GoogleのGeminiや、アンスロピックのClaud3.5sonnetなどと比較するとChatGPT4の回答速度の遅さが気になっていました。その点では、ちょうどよいタイミングの発表のように感じました。

ChatGPT4o-mini

ChatGPT4o-miniは小型AIモデル

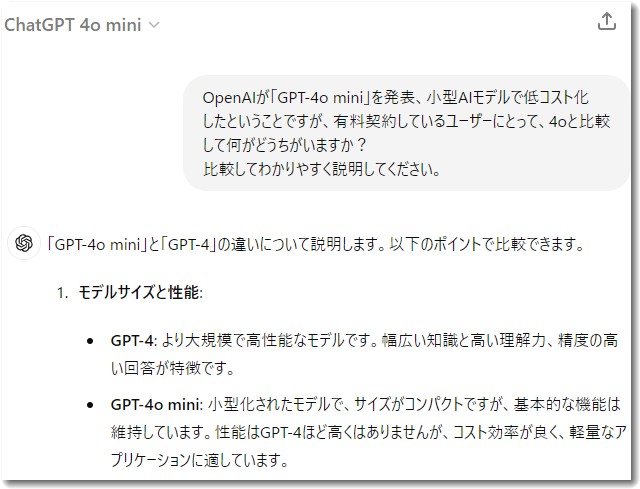

早速、ChatGPTの4o-miniを使ってみました。

以下、実際のやりとりを記録しましたので紹介しておきます。

OpenAIが「GPT-4o mini」を発表、小型AIモデルで低コスト化したということですが、有料契約しているユーザーにとって、4oと比較して何がどう違いますか?

比較してわかりやすく説明してください。

「GPT-4o mini」と「GPT-4」の違いについて説明します。以下のポイントで比較できます。

- モデルサイズと性能:

- GPT-4: より大規模で高性能なモデルです。幅広い知識と高い理解力、精度の高い回答が特徴です。

- GPT-4o mini: 小型化されたモデルで、サイズがコンパクトですが、基本的な機能は維持しています。性能はGPT-4ほど高くはありませんが、コスト効率が良く、軽量なアプリケーションに適しています。

- コスト:

- GPT-4: 高性能ゆえに、利用料金は高く設定されています。

- GPT-4o mini: 小型化されているため、利用料金が低く抑えられています。予算が限られている場合や、コストを重視するユーザーにとって有用です。

- 用途:

- GPT-4: 高度なタスク、複雑な質問応答、クリエイティブな作業など幅広い用途に対応します。

- GPT-4o mini: よりシンプルなタスクや、コストを抑えたいがある程度の性能が求められる用途に適しています。

- 応答速度とリソース:

- GPT-4: 高性能ですが、その分計算リソースが多く必要です。

- GPT-4o mini: 軽量化されているため、計算リソースの消費が少なく、応答速度が向上する可能性があります。

要するに、GPT-4o miniはコストを抑えつつも基本的な性能を持ち、GPT-4のような高性能が必要ない場合やコスト重視の状況に適しています。GPT-4は高い精度と幅広い用途に対応していますが、その分コストが高くなる傾向があります。

API接続する場合はコスト低減が期待できるようです

ChatGPTにAPI接続するとトークン量によって接続コストがかかります。GPT-4o miniはそのコストを抑えてつつ基本性能はキープしているというようなことです。

では、API接続せずに、WEB画面やスマホアプリでChatGPTを使い場合のユーザーメリットはなんでしょうか?

API接続していない場合は、ユーザーにとってコストは変わらないですよね。

ミニを使う積極的な理由かあるとすれば回答速度が早くなることです。実際にはどれくらい早いですか?

API接続していない場合でも、GPT-4o miniを使用するメリットはあります。特に、回答速度の向上が期待できる点です。具体的な速度向上の度合いはモデルの設計やサーバーの負荷状況に依存しますが、一般的には以下のような点が挙げられます。

- 計算リソースの最適化:

- GPT-4o miniは軽量化されており、計算リソースの消費が少なくなるため、処理が高速になります。これにより、応答速度が速くなる可能性があります。

- 実際の速度向上:

- GPT-4o miniの速度向上は具体的なケースにより異なりますが、一般的には従来の大規模モデルよりも数ミリ秒から数十ミリ秒程度の改善が期待されます。特に大量のリクエストを処理する場合やリアルタイム性が求められるアプリケーションでは、顕著な差を感じることがあります。

- コストとパフォーマンスのバランス:

- 小型モデルの利用により、コストが抑えられるだけでなく、実際の処理速度が向上することで、ユーザー体験が改善されることがあります。

これにより、特にリソースが限られている環境や、リアルタイム処理が求められる場面では、GPT-4o miniが有利です。具体的な速度改善の度合いは実際の使用ケースでのベンチマークやテストに依存しますが、一般的には改善が見込まれるでしょう。

確かに回答速度は早いです

ここまで利用してみましたが、確かに「GPT-4o mini」の回答速度は早いです。では、どれくらい早くなったのかということについて回答を求めてみました。

「GPT-4o mini」の回答速度は「GPT-4o」と比較してどれくらい早いですか?

なんらかのベンチマーク指標があれば表示してください。

「GPT-4o mini」と「GPT-4o」の回答速度については、公式のベンチマーク指標が公開されていないため、正確な比較は難しいですが、一般的な傾向として以下のような点が考えられます。

- モデルサイズによる影響:

- GPT-4o miniは、より小型化されているため、計算リソースの消費が少なく、応答速度が速くなることが期待されます。具体的には、処理時間が数ミリ秒から数十ミリ秒程度短縮される可能性があります。

- 実際の応答速度:

- GPT-4o miniの応答速度が具体的にどれくらい早いかは、テストや使用状況によって異なるため、公式な数値は公開されていません。ですが、一般的には「mini」モデルはフルサイズモデルよりも短時間で応答できるとされています。

- ユーザー体験:

- 実際に使用する場合、APIのリクエストからレスポンスまでの時間が短縮されることで、ユーザーの体験が改善されるでしょう。特に、高頻度でリクエストを送信するような場合には、速度の向上が顕著に感じられることがあります。

現時点での具体的なベンチマーク指標や公式データがないため、詳細な比較は困難ですが、一般的な性能向上のトレンドとして「GPT-4o mini」が「GPT-4o」よりも高速であると予想されます。

結論:「GPT-4o mini」は回答速度が早い

実際に使ってみると、たしかに「GPT-4o mini」の回答速度は早いです。レスポンスが俊敏で、入力してエンターを押すと瞬時に回答が生成される感じです。

ただし、生成AIは開発競争が激化しており、毎週のように新たなトレンドが出てくる状況です。これからどうなるのかはまだまだわからないですね。

この記事を書いた遠田幹雄は中小企業診断士です

遠田幹雄は経営コンサルティング企業の株式会社ドモドモコーポレーション代表取締役。石川県かほく市に本社があり金沢市を中心とした北陸三県を主な活動エリアとする経営コンサルタントです。

小規模事業者や中小企業を対象として、経営戦略立案とその後の実行支援、商品開発、販路拡大、マーケティング、ブランド構築等に係る総合的なコンサルティング活動を展開しています。実際にはWEBマーケティングやIT系のご依頼が多いです。

民民での直接契約を中心としていますが、商工三団体などの支援機関が主催するセミナー講師を年間数十回担当したり、支援機関の専門家派遣や中小企業基盤整備機構の経営窓口相談に対応したりもしています。

保有資格:中小企業診断士、情報処理技術者など

会社概要およびプロフィールは株式会社ドモドモコーポレーションの会社案内にて紹介していますので興味ある方はご覧ください。

お問い合わせは電話ではなくお問い合わせフォームからメールにておねがいします。新規の電話番号からの電話は受信しないことにしていますのでご了承ください。

【反応していただけると喜びます(笑)】

記事内容が役にたったとか共感したとかで、なにか反応をしたいという場合はTwitterやフェイスブックなどのSNSで反応いただけるとうれしいです。

本日の段階で当サイトのブログ記事数は 6,853 件になりました。できるだけ毎日更新しようとしています。

遠田幹雄が利用しているSNSは以下のとおりです。

facebook https://www.facebook.com/tohdamikio

ツイッター https://twitter.com/tohdamikio

LINE https://lin.ee/igN7saM

チャットワーク https://www.chatwork.com/tohda

また、投げ銭システムも用意しましたのでお気持ちがあればクレジット決済などでもお支払いいただけます。

※投げ銭はスクエアの「寄付」というシステムに変更しています(2025年1月6日)

※投げ銭は100円からOKです。シャレですので笑ってご支援いただけるとうれしいです(笑)

株式会社ドモドモコーポレーション

石川県かほく市木津ロ64-1 〒929-1171

電話 076-285-8058(通常はFAXになっています)

IP電話:050-3578-5060(留守録あり)

問合→メールフォームからお願いします

法人番号 9220001017731

適格請求書(インボイス)番号 T9220001017731